« Faut-il avoir peur du Big Data ? », c’était le thème d’une conférence proposée le 27 mai dernier au Collège des Bernardins à Paris.

Google, contributeur de l’IA

A propos du développement de l’intelligence artificielle[1], Christine Kerdellant, journaliste et écrivain, montre qu’avec le Project Baseline qui cherche à détecter les marqueurs biologiques avant-coureurs de maladies et de cancers, les implants rétiniens de caméras ou « Google-glass », le cerveau « connecté » ou encore les « bébés sur mesure », des embryons triés présentant des caractéristiques non désirées… Google est un acteur majeur dans ce domaine et « Google se prend pour Dieu », résume-t-elle. En France, 90% de la population utilise le moteur de recherche Google qui a revendu les données de 100 millions de personnes sans leur consentement.

La situation de la Chine, qui investit massivement dans le domaine de l’intelligence artificielle, mérite, selon elle, une réflexion en France afin d’éviter un sort semblable. En 2020, 1 milliard de chinois seront suivis grâce à des vidéos (170 millions de caméras) ; un système de « crédit social » est instauré dans lequel chaque individu se voit attribuer une note dans différents endroits et services : les banques, le fisc, les sites de commerce électronique… Ceux-ci sont jugés « dignes » ou non, contraints à mieux respecter les règles et à accroitre leur « sociabilité ».

La journaliste alerte son auditoire sur les risques d’une société « augmentée », constituée d’une élite aux compétences considérablement amplifiées par les nouvelles technologies et le reste de la population qui n’y aura pas accès.

En réaction, Christine Kerdellant suggère de dénoncer le caractère destructeur de ces projets pour la démocratie : les contestations ont, par exemple, contraint Google à renoncer au projet de « Google glass ». Elle invite à renoncer aux algorithmes prédictifs qui « enferment l’homme dans son destin », conduisent à un « déterminisme social » et à de profondes injustices[2], pour préférer l’utilisation de moteurs de recherche plus éthiques tels que Qwant, et enfin, de réguler l’utilisation des données.

A contrario, les deux autres intervenants, Bernard Nordinguer[3], chirurgien à Ambroise Paré, et Jacques Lucas, médecin et vice-président du Conseil national de l’Ordre des médecins, ont fait l’apologie du Big Data.

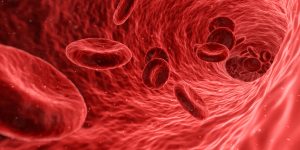

Les enjeux de l’IA dans la santé

Le premier souligne les progrès dans le domaine de la santé liés à l’introduction de l’intelligence artificielle : dans l’imagerie, dans la recherche où les données cliniques et génétiques entre laboratoires sont partagées, dans le domaine de la détection et du traitement de tumeurs, pour « l’identification des régions du génome qui contrôlent la prolifération tumorale ». Avec l’introduction des robots en chirurgie, le médecin « augmenté » sera, selon lui, « mieux informé pour établir les diagnostics et choisir les traitements ». Pour aujourd’hui, l’enjeu est de « gagner le défi de la confiance » : les données de santé « doivent être cryptées ou anonymisées pour être ouvertes à la recherche », affirme-t-il, sans cependant proposer de solution aux risques réels de leur « réidentification ».

Face aux problèmes éthiques liés à la collecte des données, Jacques Lucas rappelle que l’information et le consentement impératif du citoyen sont essentiels. Il met en garde sur la qualité des données collectées, qui n’est pas toujours « excellente » et dont l’exploitation comporte un risque de déductions « erronées ». Il souhaite interdire leur vente, pour éviter de condamner les personnes les plus vulnérables à en faire un trafic, à l’instar de ce qui peut se passer pour la vente d’organes. Jacques Lucas préconise également une réflexion au niveau européen et international pour instaurer une régulation. Selon lui, le risque de désanonymisation peut être résolu par une « gouvernance » organisée par l’Etat. Fataliste, il estime que le développement du numérique est « indispensable », si nous ne voulons pas « devenir les vassaux des Etats-Unis et de la Chine ».

Comment empêcher le piratage de données ? Être sûrs que ces données ne pourront être réutilisées par des employeurs, des banques, des assureurs à des fins discriminantes ? Hormis l’évocation d’un « principe de transparence », il semble qu’aucune solution concrète n’ait été envisagée.

Pour aller plus loin :

Big data et santé : nouvel avis du Comité d’éthique

Données de santé : des experts inquiets

Données de santé : le Conseil de l’Europe fait ses recommandations

IA : des rapports insuffisants face à l’urgence d’un cadre éthique solide

Intelligence artificielle et médecine, le miroir aux alouettes ?

Tests génétiques : vers une évolution du consentement éclairé ?

La sécurisation des données de l’application Ovia Health n’est pas assurée

[1] Certains prisonniers américains se voient par exemple privés de liberté conditionnelle parce que des algorithmes ont prévenu d’un risque de récidive (mère célibataire…).

[2] Ce sujet a fait l’objet de son livre Dans la Google du loup.

[3] Co-auteur avec Cédric Villani de La santé et l’intelligence artificielle.